- deep learning

- Weight initialization

- SPP-Net

- image classification

- Convolution 종류

- Optimizer

- 딥러닝

- object detection

- LeNet 구현

- overfeat

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Today

- Total

목록Deep Learning/Fundamental (7)

I'm Lim

Introduction 딥러닝은 optimizer로 Gradient Descent 기반의 기법을 사용합니다. 그러나, Quasi-Newton Method라는 다른 대안도 있습니다. 이 글에서는 왜 Quasi-Newton Method가 아닌 Gradient Descent을 사용하는지에 대해 알아보려고 합니다. Gradient Descent Gradient Descent의 기본적인 공식은 아래와 같습니다. θ=θ−η∇θJ(θ) Gradient Descent은 극소점을 찾는 것이 그 목적입니다. 위 식을 보면 알 수 있듯이, J(θ) 즉, 기울기가 0이 되버리는 순간에는 더 이상 θ가 변하지 않고, ..

Vanishing gradient / Exploding gradient

Vanishing gradient / Exploding gradient

Vanishing gradient & Exploding gradient 모델의 성능 개선을 위해 가장 우선적으로 고려해볼 수 있는 경우는 모델의 레이어를 깊이 쌓는 일이다. 하지만, 레이어를 깊이 쌓으면 학습 도중에 가중치의 기울기가 사라지는 현상 혹은 폭발적으로 커지는 현상이 발생한다. 이를 각각 Vanishing gradient / Exploding gradient problem이라 한다. 1. Vanishing gradient 1 ) Vanishing gradient의 원인 딥러닝은 Back propagation 연산 시, Activation function의 편미분 값과 모델의 가중치 값들을 이용하게 된다. Activation function 글에서 살펴봤듯이, sigmoid나 tanh를 사용하게..

Activation function / Overfitting problem

Activation function / Overfitting problem

1. Activation function Vanishing gradient나 Exploding gradient 문제를 이야기하기 앞서 대표적인 Activation function을 소개해야할 것 같다. 1 ) Sigmoid Sigmoid 함수의 수식은 σ(x)=11+e−x이다. Sigmoid 함수의 미분 식은 σ′(x)=σ(x)(1−σ(x))이다. 주목할 점은 0≤σ′(x)≤0.25라는 것이다. 2 ) Tanh tanh 함수의 식은 tanh(x)=ex−e−xex+e−x다. tanh 함수의 미분 식은 $tanh'(x) = 1 - tanh^{2}(x..

Global Minima / Local Minima / Saddle Point

Global Minima / Local Minima / Saddle Point

Global Minimum loss function에서 loss 값이 가장 작은 지점. 이 지점에 도달하는 것이 딥러닝 학습의 최종 목표이다. Local Minimum Global Minimum이 아닌 극소점. 이것이 문제가 되는 이유는 딥러닝에서는 Gradient Descent를 이용하여 가중치 업데이트를 하는데 (θ=θ−η∗J(θ); BGD) 극소점에서는 모든 가중치들의 기울기 값이 0이 되므로 더이상 가중치를 업데이트 시키지 못하기 때문이다. Saddle Point - Paper : Dauphin, Yann N., et al. "Identifying and attacking the saddle point problem in high-dimensional..

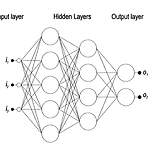

Multi Layer Perceptron

Multi Layer Perceptron

Paper Gardner, M. W., & Dorling, S. R. (1998). Artificial neural networks (the multilayer perceptron)—a review of applications in the atmospheric sciences. Atmospheric environment, 32(14-15), 2627-2636. 논문이 가지는 의미 인공지능망이 어떤 프로세스를 거쳐서 학습이 되는지 또 인공지능망을 적용한 예시 등을 보여줌으로써 기초적인 딥러닝의 학습방식을 이해할 수 있다. 논문의 내용 1. 딥러닝의 장점 1) 입력 데이터 분포에 대한 사전지식이 없어도 된다. 기존의 statistical model (e.g., Linear Regression, Logisti..

Back Propagation

Back Propagation

Paper Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. nature, 323(6088), 533-536. 논문이 가지는 의미 퍼셉트론이 XOR문제를 해결하지 못하자 MLP가 등장하였고, 그에 따라 weight와 bias의 개수가 급등하였다. 이런 상황에서 weight update를 효율적으로 할 수 있는 방안이 필요했고, 그 중 하나가 Back-propagation 방식이다. 현재 딥러닝에서도 Back propagation을 이용하여 모델의 weight를 update시킨다는 점에서 중요한 논문이라 할 수 있다. 논문의 내용 1. Hidden layer..

The Perceptron

The Perceptron

Paper Rosenblatt, F. (1958). The perceptron: a probabilistic model for information storage and organization in the brain. Psychological review, 65(6), 386. 논문이 가지는 의미 최초의 Multi Layer Perceptron(MLP)에 대한 논문으로써 인공지능의 기원을 살펴볼 수 있다. 논문의 내용 1. 사람은 어떤 정보를 기억하는가? 1 ) One-to-one mapping : 어떤 정보를 고유의 코드화를 시켜서 저장한다는 것. 이 가설은 단순하여 임베딩이 쉽고, 직관적으로 이해하기 쉽다는 장점이 있다. 2 ) Central Nervous System (CNS) : 특정 정보를 임베..