- image classification

- SPP-Net

- 딥러닝

- deep learning

- Optimizer

- object detection

- Convolution 종류

- overfeat

- LeNet 구현

- Weight initialization

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- Today

- Total

I'm Lim

The Perceptron 본문

Paper

Rosenblatt, F. (1958). The perceptron: a probabilistic model for information storage and organization in the brain. Psychological review, 65(6), 386.

논문이 가지는 의미

최초의 Multi Layer Perceptron(MLP)에 대한 논문으로써 인공지능의 기원을 살펴볼 수 있다.

논문의 내용

1. 사람은 어떤 정보를 기억하는가?

1 ) One-to-one mapping

: 어떤 정보를 고유의 코드화를 시켜서 저장한다는 것. 이 가설은 단순하여 임베딩이 쉽고, 직관적으로 이해하기 쉽다는 장점이 있다.

2 ) Central Nervous System (CNS)

: 특정 정보를 임베딩시켜서 기록하는 것이 아닌 Central Neural System의 Network를 새로 생성 및 수정하면서 기억을 저장한다는 것. 이 가설에서는 정보는 임베딩 형식이 아닌 특정 반응에 대한 선호도(Preference)로 저장 되어야 한다고 주장했다. 즉, 정보가 connection 이나 association의 형태로 저장된다고 주장했다.

두 번째 가설을 주장하는 사람들을 일컬어 "Connectionist"라 한다. 현재도 간혹 쓰이는 "Perceptron"이라는 용어는 CNS network를컴퓨터 프로그래밍으로 구현시킨 것이다. 따라서, Perceptron은 인간의 CNS network를 모방하기 위해 만들어진 것이라고 할 수 있다.

2. 인공지능망의 변천사

이 논문이 나온 시기 이전에는 symbolic logic (즉, boolean algebra로 on / off 하는 방식)이 주를 이루었지만, 이 논문이 나온 시기부터 probability theory로 Perceptron을 구성하였다.

probability theory를 주장하는 사람들은 유사한 자극은 같은 노드를 지나갈 것이라고 주장했는데, 이 때 유사한 자극은 외관상으로 보이는 특징일 필요는 없다고 하였다. 또한, dissimilarity 가 큰 자극이 connection를 변화시킬 것이라고 주장했다.

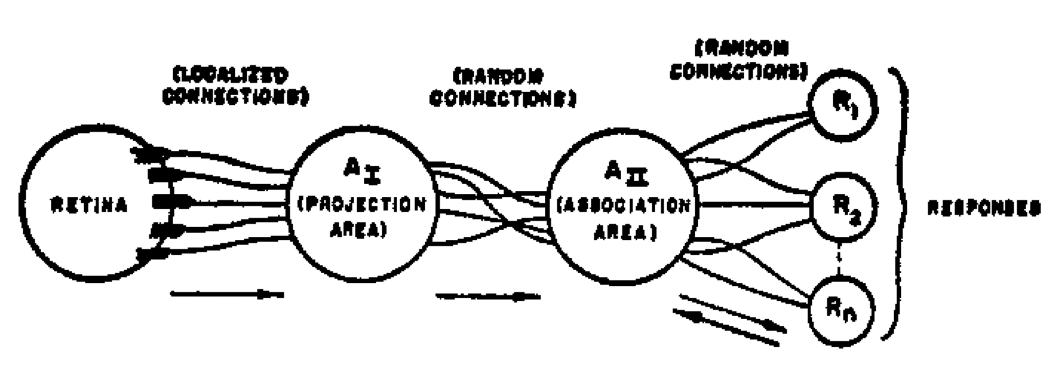

3. Perceptron의 프로세스

1 ) 시각 정보가 입력으로 주어지면 Retina라고 불리는 S-point에서 연산을 거쳐서 A-units으로 전달한다. 이 때 연산은 크게 두가지 방식이 있는데 하나는 all-or-nothing ( 1 / 0 ) 이고, 다른 하나는 자극의 강도에 비례한 값으로 연산하는 것이다. 이 논문은 all or nothing 방식을 채택했다.

2 ) 연산을 거쳐 얻은 값을 A-units의 $A_I$(projection area)의 입력으로 주어진다. S-point에서 $A_I$으로 연결된 노드들을 $A_I$의 origin point라고 한다. 이 origin point들은 A-unit을 활성화 시킬 수도 있고, 억제 시킬 수도 있다.

3 ) 만약 origin point들에 의해 연산된 값들의 algebraic sum이 특정 thereshold보다 높다면 A-unit이 활성화 된다. (all or nothing)

4 ) $A_{II}$와 $A_I$ 사이의 노드들은 랜덤으로 정의가 되고, 이 노드는 feed forward방식이다.

5 ) R-points들은 $A_{II}$와 랜덤하게 연결된다. 이와 같이 response와 직접 연결되어있는 A-unit들을 response의 source set이라고 한다. 이 response와 A-unit을 연결하는 connection들은 both direction이다. feedback은 connection을 강하게 만들 수도 있고, 약하게 만들 수도 있다.

회고

Perceptron은 현재 딥러닝의 구조의 근간인 것은 맞으나, 어느정도의 차이가 존재한다. 현재 딥러닝 신경망은 threshold를 기준으로 출력을 1로 주거나 0으로 주는 all-or-nothing 방식이 아니라 출력을 활성화 함수(activation function)에 mapping 시키는 방식을 사용한다.

'Deep Learning > Fundamental' 카테고리의 다른 글

| Vanishing gradient / Exploding gradient (0) | 2022.11.29 |

|---|---|

| Activation function / Overfitting problem (0) | 2022.11.28 |

| Global Minima / Local Minima / Saddle Point (0) | 2022.09.18 |

| Multi Layer Perceptron (0) | 2022.08.09 |

| Back Propagation (0) | 2022.08.08 |